A medida que continúan los avances en robótica e inteligencia artificial, los esfuerzos para hacer que los robots sean menos espeluznantes e inquietantes y más amigables y parecidos a los humanos son una opción codiciada. nicho de desarrollo. Ahora, investigadores financiados con fondos federales afirman haber creado un robot que puede imitar las expresiones faciales de la persona que lo está hablando.

En recientemente artículo publicado, los investigadores que trabajan con una subvención de la Fundación Nacional de Ciencias explicaron cómo construyeron su robot más nuevo, “Emo”, y los esfuerzos que realizaron. se tomó para hacer que la máquina respondiera mejor a las interacciones humanas. Al comienzo del artículo, los investigadores señalan la importancia de la interacción humana. sonreír en el espejo social:

Pocos gestos son más entrañables que una sonrisa. Pero cuando dos personas se sonríen simultáneamente, el efecto se amplifica: no sólo el sentimiento mutuo pero también que ambas partes ejecuten la sonrisa simultáneamente, probablemente podrán inferir correctamente el estado mental del otro con antelación.

El nuevo robot de los investigadores es un “robot facial antropomórfico”. Este no es su primer robot. Una iteración anterior del robot fue denominada “ Eva”. Sin embargo, los investigadores dicen que Emo es notablemente más avanzado que Eva.

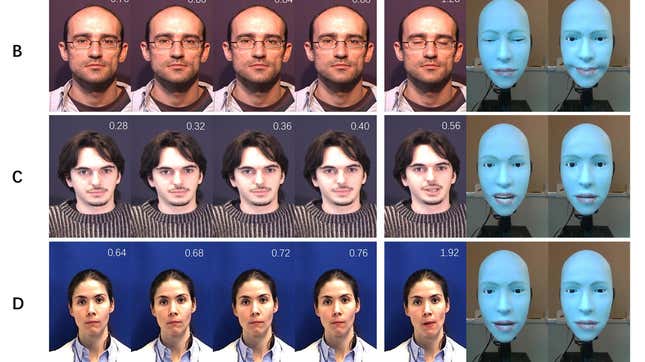

El objetivo de Emo era lograr lo que los investigadores llaman “coexpresión”, o la emulación simultánea de la expresión facial de un conversador humano. Para ello, los investigadores desarrollaron un algoritmo predictivo que fue entrenado en un gran conjunto de datos de video de humanos haciendo expresiones faciales. Los investigadores afirman que el algoritmo que han desarrollado es capaz de “predecir la expresión objetivo que una persona producirá basándose en cambios iniciales y sutiles en su cara”. Luego, el algoritmo comunica al hardware del robot qué configuración facial emular en “tiempo real”, dicen los investigadores.

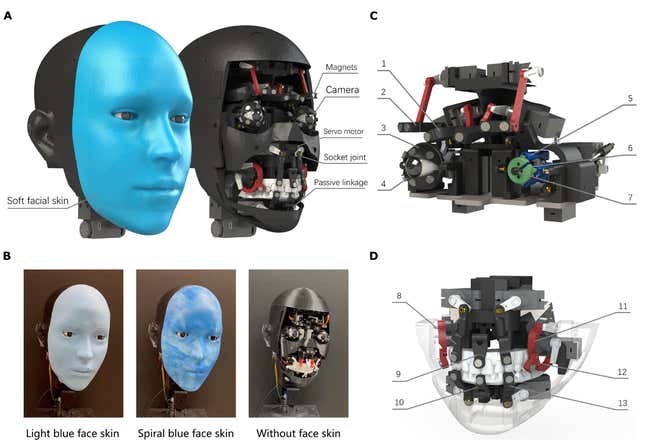

En realidad, lograr que el robot haga una expresión facial es una historia diferente. Las diversas configuraciones faciales del robot funcionan con 26 motores diferentes y 26 actuadores. Los investigadores dicen que la mayoría de los motores están “distribuidos simétricamente”, es decir, que están diseñados para crear expresiones simétricas, con con excepción del que controla la mandíbula del robot. Tres motores controlan los movimientos del cuello del robot. Los actuadores, por su parte, permiten creación de expresiones más asimétricas.

Emo también viene equipado con una “piel” de silicona intercambiable que se fija a la cara del robot mediante 30 imanes. Los investigadores señalan que esta piel puede ser “reemplazado con diseños alternativos para una apariencia diferente y para el mantenimiento de la piel», haciendo la cara personalizable. El robot también tiene “ojos, ”que están equipadas con cámaras RGB de alta resolución. Estas cámaras permiten a Emo ver a su participante en la conversación y así emular su expresión facial.

Al mismo tiempo, los investigadores escriben que implementan lo que ellos llaman un “marco de aprendizaje que consta de dos redes neuronales, una para predecir los emo”. propia expresión facial (el automodelo) y otro para predecir la expresión facial del conversador (el modelo conversante)”. Cuando colocas el software y hardware juntos, lo que obtienes es una máquina que puede hacer cosas como esta:

Una versión de esta historia se publicó originalmente en Gizmodo.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.