Como de costumbre, Google I/O 2024 es un torbellino absoluto de noticias y anuncios. Este año, en lugar de centrarse en el hardware, Android o Chrome, Google dedicó la mayor parte la conferencia de desarrolladores de este año nos convence de que es Funciones de IA Vale la pena priorizar. Uno de esos proyectos es el Proyecto Astra, un asistente de IA multimodal con el que puedes semiconversar y que puede usar simultáneamente el cámara para identificar objetos y personas.

Digo “semi” porque es evidente después de la demostración que esta parte de Gemini está en su infancia. Pasé unos breves minutos con Proyecto Astra en la Píxel 8 Pro para ver cómo funciona en tiempo real. No tuve suficiente tiempo para probarlo en toda su extensión o intentarlo engañarlo, pero tengo una idea de cómo se sentirá el futuro como usuario de Android.

Pregúntale casi cualquier cosa

El objetivo del Proyecto Astra es ser como un asistente que también te guía en el mundo real. Puede responder preguntas sobre el entorno que te alrededor identificando objetos, rostros, estados de ánimo y textiles. Incluso puede ayudarte a recordar dónde colocaste algo por última vez.

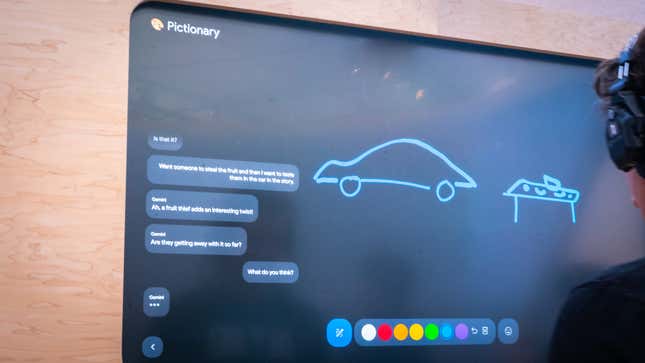

Hubo cuatro demostraciones diferentes para elegir para el Proyecto Astra. Incluían el modo Narrador, que le pide a Géminis que invente una historia basada en varias entradas y Pictionary, esencialmente un juego de adivinar garabatos con la computadora. También había un modo de aliteración, donde la IA mostró su destreza para encontrar palabras con la misma letra inicial y Free-Form le permitió conversar de un lado a otro.

La demostración que obtuve fue una versión de Free-Form en el Pixel 8 Pro. Otro periodista de mi grupo la había solicitado directamente, por lo que la mayor parte de nuestra demostración se centró en usar el dispositivo y este modo de asistente juntos.

Con la cámara apuntando a otro periodista, el Pixel 8 Pro, y Gemini pudieron identificar que el sujeto era una persona, le dijimos explícitamente es que la persona se identificó como un hombre. Luego, identificó correctamente que llevaba su teléfono. En una pregunta de seguimiento, nuestro grupo preguntó sobre su ropa. Dio una respuesta generalizada de que “parece estar usando ropa informal”. Luego, preguntamos qué estaba haciendo, a lo que Proyecto Astra respondió que parecía que se estaba poniendo un par de gafas de sol (estaba) y golpeando una pose informal.

Tomé el Pixel 8 Pro por un rápido minuto. Conseguí que Gemini identificara una maceta de flores faldas correctamente. eran tulipanes. Géminis notó que también eran coloridos. A partir de ahí, no estaba seguro de qué más sugerirlo, y luego mi tiempo. estaba levantado. Me fui con más preguntas de las que tenía al entrar.

Con la IA de Google, parece un acto de fe. Puedo ver cómo identificar a una persona y sus acciones podría ser una accesibilidad herramienta para ayudar a alguien que es ciego o tiene baja visión mientras navega por el mundo que lo rodea. Pero eso no es lo que fue esta demostración sobre. Fue para mostrar las capacidades del Proyecto Astra y cómo interactuaremos con él.

Mi mayor pregunta es: ¿Algo como el Proyecto Astra reemplazará al Asistente de Google en dispositivos Android? Después de todo, esta IA puede recordar dónde colocas sus cosas y captar los matices, al menos eso es lo que transmitió la demostración. No pude obtener una respuesta de los pocos Google Amigos, les pregunté. Pero tengo un fuerte presentimiento de que el futuro de Android se tratará menos de tocar para interactuar con el teléfono y más dependiente de hablar con él.

A version of this article originally appeared on Gizmodo.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.