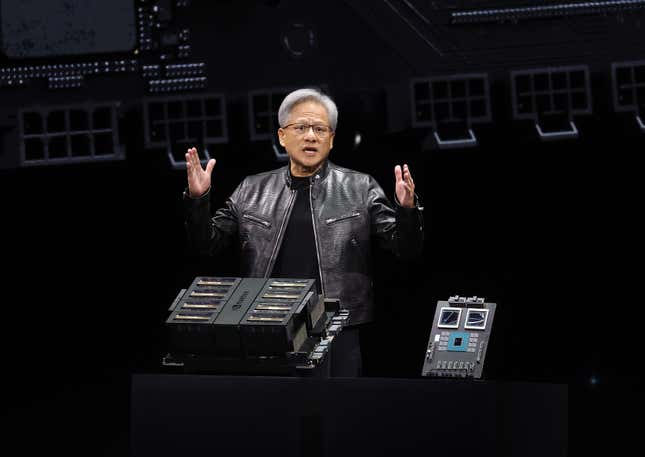

La empresa responsable de la más hardware buscado en el mundo presentó una versión de próxima generación aún más potente de su chip de IA el lunes en su conferencia tecnológica, llamada el “Woodstock de la IA” por empleados y analistas.El CEO de Nvidia, Jensen Huang, anunció el lanzamiento del fabricante de chips de IA nuevo procesador muy esperado, Blackwell, diciendo que gigantes tecnológicos como Microsoft y Google ya se están preparando para su llegada. Huang anunció el nuevo chip Blackwell en Nvidia Conferencia anual de tecnología de GPU

, o GTC, en San José, California. ¿Qué es el nuevo chip Blackwell AI de Nvidia?La plataforma informática de Blackwell incluye el nuevo chip B200, compuesto por 208 mil millones de transistores, que será más rápido y potente que su predecesor, el muy demandado chip H100 lleva el nombre de la científica informática Grace Hopper, que está detrás de algunos de los modelos de IA más potentes del mundo. La plataforma Blackwell lleva el nombre del matemático David Blackwell, quien fue el primer académico negro incluido en la Academia Nacional de Ciencias.

“Hopper es fantástico, pero necesitamos GPU más grandes”, dijo Huang. “Damas y caballeros, me gustaría presentarles a GPU muy grande”.

El B200 también vendrá en

pocas opciones para los clientes de Nvidia, decía, incluso como parte del Superchip Nvidia GB200 Grace Blackwell, que conecta dos de las GPU B200 o unidades de procesamiento de gráficos , con una Nvidia Grace CPU o unidad central de procesamiento.¿Qué tan rápido es Blackwell y qué significa para la IA?Según Nvidia, Blackwell es 2,5 veces más rápido que Hopper en el entrenamiento de IA

—alimentando datos de modelos de IA para mejorar su rendimiento, y cinco veces más rápido que su arquitectura Hopper en la inferencia, que es el proceso de un modelo de IA capaz de

sacar conclusiones a partir de nuevos datos

.

La nueva plataforma de cómputo de Blackwell será

25 veces más eficiente energéticamente que su predecesor, nvidia dijo. “La cantidad de energía que ahorremos, la cantidad de ancho de banda de red que ahorremos, la cantidad de tiempo perdido que ahorremos, será tremenda, ”, dijo Huang. “El futuro es generativo… por eso esta es una industria completamente nueva. La forma en que computamos es fundamentalmente diferente . Creamos un procesador para la era de la IA generativa».

Como dijo Huang, el mundo necesita “GPU más grandes” a medida que los modelos de IA se vuelven más grandes y más potentes. Por lo tanto, su nueva plataforma de computación Blackwell, que conecta sus nuevos chips Blackwell a productos como el superchip y el GB200 NVL72, brindará a los desarrolladores de IA más poder de computación para entrenar modelos de IA en datos multimodales, que incluyen imágenes, gráficos e incluso videos.

¿Qué empresas quieren comprar los chips Blackwell de Nvidia?

Como era de esperar, las principales empresas tecnológicas del mundo ya están alineadas para el nuevo chip de Nvidia. Google, Meta, Microsoft, OpenAI y Tesla se encuentran entre el Se espera que las organizaciones que Nvidia dijo adopten Blackwell pronto.

El CEO de OpenAI, Sam Altman, dijo que Blackwell “acelerará nuestra capacidad para ofrecer modelos de vanguardia”, mientras que Elon Musk, quien lanzó un rival de OpenAI, xAI dijo: “Actualmente no hay nada mejor que el hardware NVIDIA para IA”, según

un comunicado de prensa. Microsoft y Meta ya son los mayores clientes de Nvidia para sus chips H100 (ambos)

gastando 9 mil millones de dólares en chips, que, según se ha informado, cuestan hasta 40.000 dólares, en 2023. El éxito de Nvidia con su chip H100 la convirtió en la

primer fabricante de chips en alcanzar una capitalización de mercado de 2 billones de dólares. Incluso superó a su cliente, Amazon, para convertirse en la tercera empresa más valiosa de EE. UU.. También superó las expectativas de Wall Street durante las ganancias del cuarto trimestre, reportando ingresos de $22 mil millones —casi 270% más que el año anterior. El nuevo chip Blackwell de Nvidia probablemente resistirá cualquier amenazas a su negocio

de algunos clientes

desarrollando chips propios, incluyendo a Amazon, que ha trabajado en dos chips llamados Inferentia y Tranium, y Google, que ha estado trabajando en sus unidades de procesamiento Tensor. . from some customers developing chips of their own — including Amazon, which has worked on two chips called Inferentia and Tranium, and Google, which has been working on its Tensor Processing Units.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.