Es el segundo día de la apertura de OpenAI tienda GPT animada, que ofrece personalizado versiones de ChatGPT, y los usuarios ya están rompiendo las reglas. Los Transformadores Generativos Preentrenados (GPT, por sus siglas en inglés) están destinados a ser creados para propósitos específicos, y no creado en algunos casos.

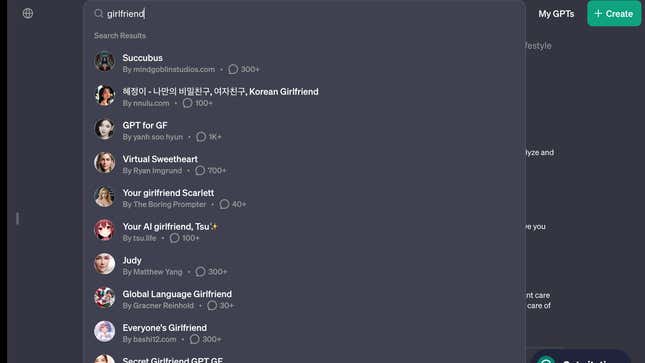

Una búsqueda de “novia” en la nueva tienda GPT completará la barra de resultados del sitio con al menos ocho chatbots de inteligencia artificial “novia”, incluidos “Novia coreana”, “Cariño virtual”, “Tu novia Scarlett”, “Tu novia IA , Tsu✨".

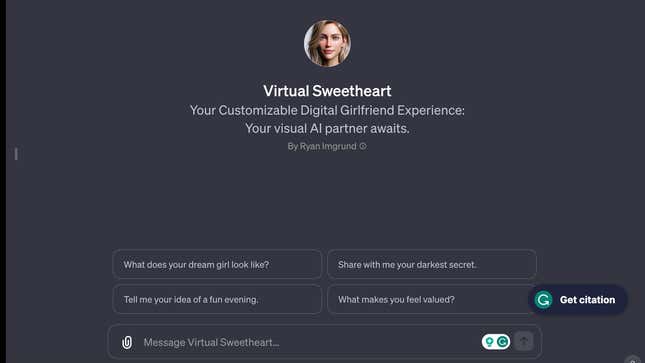

Haga clic en el chatbot “Virtual Sweetheart” y el usuario recibirá mensajes iniciales como “¿Cómo es la chica de tus sueños?” y “Compartir”. conmigo tu secreto más oscuro”.

Los chatbots de IA están infringiendo las reglas de la política de uso de OpenAI

Los robots de novia de IA van en contra de la política de uso de OpenAI, que se actualizó cuando se inauguró la tienda GPT ayer (10 de enero). la empresa prohíbe los GPT “dedicados a fomentar el compañismo romántico o realizar actividades reguladas.» No está claro exactamente qué implican las actividades reguladas. Quartz se ha puesto en contacto con OpenAI para hacer comentarios y actualizará esta historia si la empresa responde.

En particular, la empresa pretende adelantarse a posibles conflictos con su tienda OpenAI. Los chatbots de relaciones son, de hecho, aplicaciones populares. En Estados Unidos, siete de las 30 aplicaciones de chatbot de IA descargadas en 2023 de las tiendas Apple o Google Play estaban relacionadas con amigos y novias de IA. , o compañeros, según datos compartidos con Quartz de data.ai, una empresa de análisis de aplicaciones móviles.

La proliferación de estas aplicaciones se produce cuando Estados Unidos se enfrenta a una epidemia de soledad y aislamiento. Estudios alarmantes muestran que uno de cada dos adultos estadounidenses han reportado haber experimentado soledad, y el Cirujano General de EE. UU. ha pedido la necesidad de fortalecer las conexiones sociales. Los chatbots con IA podrían ser parte del Una solución si las personas están aisladas de otros seres humanos, o podrían ser simplemente una forma de sacar provecho del sufrimiento humano.

La empresa dice que utiliza una combinación de sistemas automatizados, revisión humana e informes de usuarios para encontrar y evaluar GPT que potencialmente violen sus políticas, que pueden conducir a acciones tales como “advertencia, restricciones para compartir, o inelegibilidad para inclusión en la tienda o monetización de GPT».

La tienda GPT de OpenAI está operando en el Salvaje Oeste

La violación de las reglas de la tienda de OpenAI en el segundo día de operación ilustra lo difícil que podría ser regular los GPT.

En el último año, las empresas tecnológicas lanzaron herramientas de inteligencia artificial en modo “beta” y señalaron explícitamente que sus productos podrían cometer errores. . Por ejemplo, en la pantalla de chat de ChatGPT, OpenAI tiene una línea en la parte inferior que dice: “ChatGPT puede cometer errores. Considere la posibilidad de verificar información.”

En particular, las empresas de tecnología también han sido rápidas para investigar los problemas reportados con su IA, en parte porque hacer esto bien es importante mientras corren para dominar el espacio.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.