Nvidia es el Taylor Swift de las empresas tecnológicas.

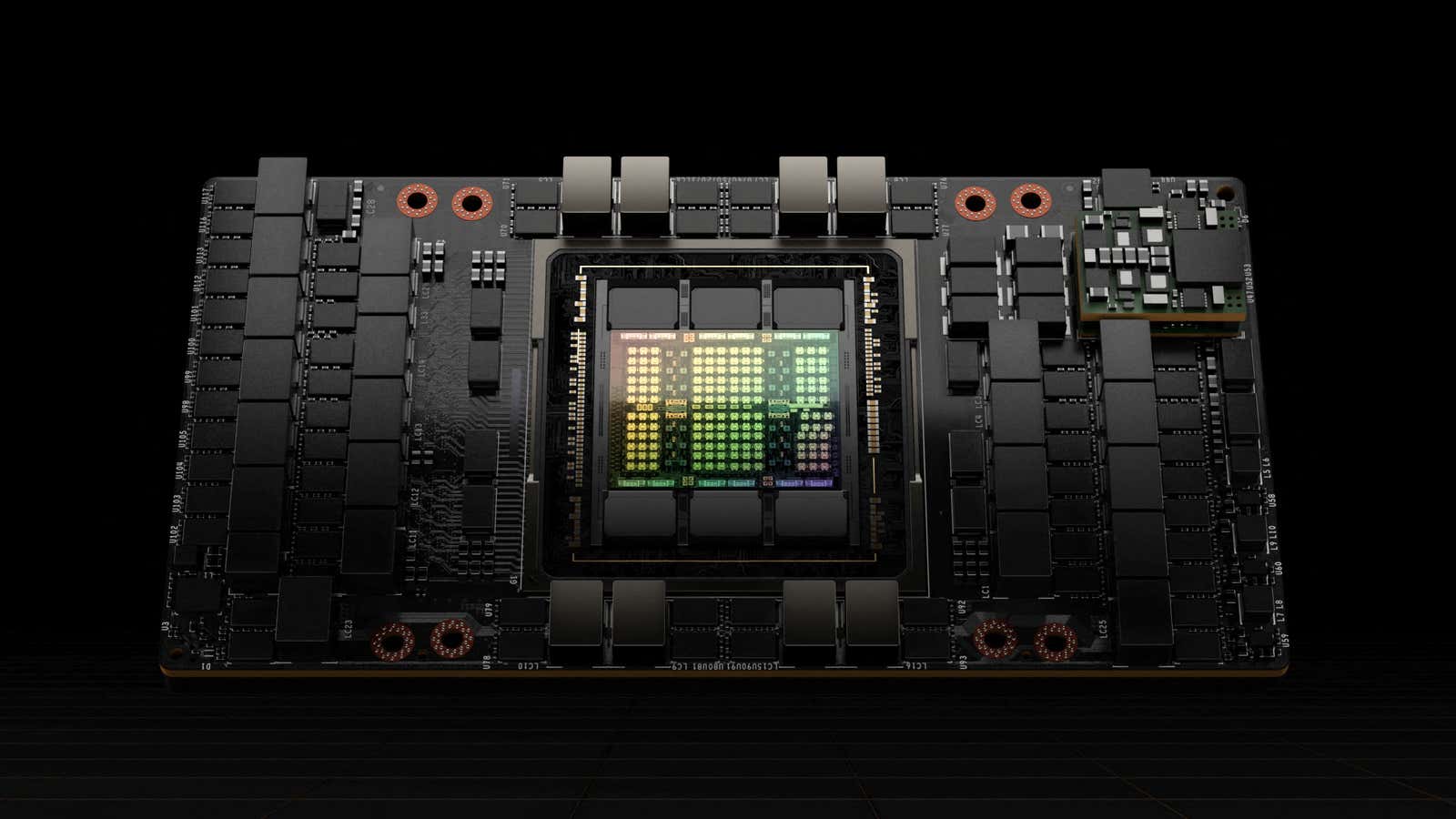

Es Clientes de IA desembolsar $40.000 por chips avanzados y, a veces, esperar meses por la tecnología de la empresa, manteniéndose leales incluso cuando debutan alternativas competitivas. Esa devoción proviene de que Nvidia es El mayor fabricante de chips de IA El juego está en la ciudad. Pero también hay razones técnicas importantes que hacen que los usuarios regresen.

Por ejemplo, no es sencillo cambiar un chip por otro: las empresas construyen sus productos de IA según las especificaciones de esos chips. Cambiar a una opción diferente podría significar volver atrás y reconfigurar los modelos de IA, una tarea costosa y que requiere mucho tiempo. y mezclar y combinar distintos tipos de chips. Y no se trata solo del hardware: CUDA, el software de Nvidia para controlar chips de IA conocidos como GPU, funciona muy bien, afirmó Ray Wang, director ejecutivo de Constellation Research, con sede en Silicon Valley. Wang afirmó que eso ayuda a fortalecer el dominio del mercado de Nvidia.

“No es que haya un bloqueo”, dijo. “Es solo que nadie ha dedicado tiempo a decir: ‘Oye, vamos a construir algo mejor’".

Eso podría estar cambiando. Durante las últimas dos semanas, Las empresas tecnológicas han comenzado a acudir al almuerzo de Nvidia, con Facebook padre Meta, Google Alfabeto padre, y AMD todos revelando chips nuevos o actualizados. Otros, incluidos Microsoft y Amazonas También hemos hecho anuncios recientes sobre productos de chips de cosecha propia.

Mientras que Es poco probable que Nvidia sea desbancada en el corto plazoEstos esfuerzos y otros podrían amenazar la reputación de la empresa. Cuota de mercado estimada del 80 % aprovechando algunas de las debilidades del fabricante de chips, sacando ventaja de un ecosistema cambiante, o ambas cosas.

Diferentes chips son mejores para diferentes tareas de IA, pero cambiar entre varias opciones es un dolor de cabeza para los desarrolladores. Incluso puede ser difícil para diferentes modelos del mismo chip, dijo Wang. Desarrollar software que pueda funcionar bien entre una variedad de chips crea nuevas oportunidades para los competidores, con Wang apuntando a una API Como una startup que ya está trabajando en un producto exactamente como ese.

“La gente se dará cuenta de que a veces necesita CPU, a veces necesita GPU y a veces necesita TPU, y obtendrá sistemas que realmente lo guiarán a través de esos tres aspectos”, dijo Wang, refiriéndose a las unidades centrales de procesamiento, las unidades de procesamiento gráfico y las unidades de procesamiento tensor, tres tipos diferentes de chips de IA.

En 2011, un capitalista de riesgo Marc Andreessen proclamó célebremente que el software se estaba comiendo al mundo.Esto sigue siendo cierto en 2024 en lo que respecta a los chips de IA, que están cada vez más impulsados por la innovación de software. El mercado de chips de IA está experimentando un cambio familiar con ecos en las telecomunicaciones, en el que los clientes comerciales pasaron de depender de múltiples componentes de hardware a soluciones de software integradas, dijo Jonathan Rosenfeld, quien dirige el grupo Fundamental AI en MIT FutureTech.

“Si nos fijamos en los avances reales en hardware, no provienen de la Ley de Moore ni nada parecido, ni remotamente”, dijo Rosenfeld, quien también es cofundador y director de tecnología de la startup de inteligencia artificial para el cuidado de la salud. somita.ai.

Esta evolución apunta hacia un futuro en el que el software juega un papel fundamental en la optimización entre diferentes plataformas de hardware, reduciendo la dependencia de un solo proveedor. Si bien CUDA de Nvidia ha sido una herramienta poderosa a nivel de un solo chip, un cambio a un panorama dependiente del software requerido por modelos muy grandes que abarcan muchas GPU no necesariamente beneficiará a la empresa.

“Es probable que veamos una consolidación”, dijo Rosenfeld. “Hay muchos participantes y mucho dinero y, definitivamente, mucha optimización que puede ocurrir”.

Rosenfeld no ve un futuro sin Nvidia como fuerza importante en el entrenamiento de modelos de IA como ChatGPT. El entrenamiento es la forma en que los modelos de IA aprenden a realizar tareas, mientras que la inferencia es cuando usan ese conocimiento para realizar acciones, como responder a las preguntas que los usuarios le hacen a un chatbot. Las necesidades informáticas para esos dos pasos son distintas y, si bien Nvidia es adecuada para la parte de entrenamiento de la ecuación, las GPU de la empresa no están tan preparadas para la inferencia.

A pesar de eso, la inferencia tuvo en cuenta Se estima que el 40% de los ingresos del centro de datos de la empresa Durante el último año, Nvidia dijo en su último informe de ganancias.

“Francamente, son mejores en el entrenamiento”, dijo Jonathan Ross, director ejecutivo y fundador de Groq, una empresa emergente de chips de inteligencia artificial. “No se puede construir algo que sea mejor en ambas cosas”.

El entrenamiento es donde se gasta dinero, y se supone que la inferencia es donde se gana dinero, dijo Ross. Pero las empresas pueden sorprenderse cuando un modelo de IA se pone en producción y requiere más potencia de procesamiento de lo esperado, lo que reduce las ganancias.

Además, las GPU, el principal chip que fabrica Nvidia, no son particularmente rápidas a la hora de generar respuestas para los chatbots. Si bien los desarrolladores no notarán un pequeño retraso durante un entrenamiento de un mes, las personas que usan chatbots quieren respuestas lo más rápidas posible.

Entonces Ross, que anteriormente trabajaba en chips en Google, inició Groq para construir chips llamados Unidades de Procesamiento de Lenguaje (LPU), que están diseñadas específicamente para la inferencia. Una prueba de terceros de Análisis artificial Descubrieron que ChatGPT podía funcionar más de 13 veces más rápido si utilizaba los chips de Groq.

Ross no ve a Nvidia como un competidor, aunque bromea diciendo que los clientes a menudo se encuentran en una posición más alta en la cola para obtener chips Nvidia después de comprar en Groq. Los ve más como un colega en el espacio, que hace la capacitación mientras Groq hace la inferencia. De hecho, Ross dijo que Groq podría ayudar a Nvidia a vender más chips.

“Cuanto más gente empiece a ganar dinero con la inferencia”, dijo, “más gastarán en formación”.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.