La era de la mala música de robots está sobre nosotros. Adobe está trabajando en una nueva herramienta de inteligencia artificial que permitirá a cualquiera ser productor musical —no se requiere experiencia en edición o instrumento.

La empresa desvelada “Proyecto Música GenAI Control”—un nombre muy largo esta semana. La herramienta permite a los usuarios crear y editar música simplemente escribiendo indicaciones de texto en un formato Modelo de IA. Estos pueden incluir descripciones como “rock poderoso”, “baile feliz” o “jazz triste”, explicó Adobe.

Project Music GenAI Control creará una melodía inicial basada en la solicitud del usuario, que también puede editar usando texto. Adobe dijo Los usuarios pueden, por ejemplo, editar la intensidad de la música generada, ampliar la duración del clip musical o crear un bucle repetible, entre otras cosas. .

La audiencia objetivo de esta nueva herramienta incluye podcasters, locutores y “cualquier otra persona que necesite audio que tenga el estado de ánimo, el tono y la longitud”, dijo Nicholas Bryan, científico investigador de Adobe y uno de los creadores de la tecnología.

“Una de las cosas interesantes de estas nuevas herramientas es que no se trata sólo de generar audio, sino que lo llevan al nivel de Photoshop al brindarles a los creativos el mismo tipo de control profundo para dar forma, modificar y editar su audio», afirmó Bryan en un blog de adobe. “Es una especie de control a nivel de píxeles para la música».

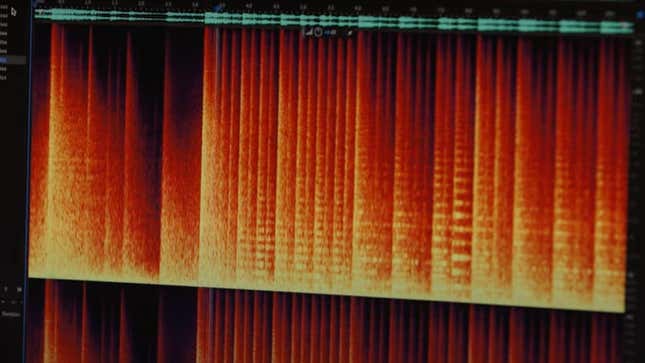

Adobe subió un vídeo que mostraba cómo funcionaba Project Music GenAI Control y daba miedo lo fácil que era para la herramienta crear música. También pareció funcionar muy rápido. Si bien la música que generó no va a ganar ningún Grammy, es algo que Definitivamente puedo imaginarme escuchando de fondo videos de YouTube, TikToks o transmisiones de Twitch.

Eso no es exactamente algo bueno. La IA ha repercutido en profesiones como escribir y actuar, obligando a los trabajadores a tomar una posición y prevenir sus los medios de vida de ser robados. Los comentarios en el video de YouTube de la compañía se hicieron eco de estas preocupaciones y criticaron a la compañía por crear “música escrita por robots, para robots» y “buenas vergüenzas corporativas”.

“Gracias Adobe por intentar encontrar aún más formas para que las corporaciones despojen a los creativos de sus empleos. Además, ¿de qué artistas robaste? ¿El material que usaste para entrenar tu IA?”, escribió un usuario.

Cuando Gizmodo le pidió comentarios, Adobe no reveló detalles sobre la música utilizada para entrenar su modelo de IA para Project Music GenAI Control. . Sin embargo, sí señaló que con Firefly, su familia de generadores de imágenes con IA, solo había entrenado sus modelos en plataformas con licencia abierta. y dominio público donde los derechos de autor habían expirado.

“El control de Project Music GenAI es una mirada muy temprana a la tecnología desarrollada por Adobe Research y aunque no revelamos los detalles de “Sin embargo, el modelo, lo que podemos compartir es: Adobe siempre ha adoptado un enfoque proactivo para garantizar que estamos innovando de manera responsable”, Anais. Gragueb, un portavoz de Adobe, le dijo a Gizmodo en un correo electrónico.

La música es arte e inherentemente humana. Como tal, debemos tener cuidado cuando se trata de nuevas herramientas como la de Adobe, o arriesgarnos a una futuro donde la música suena tan vacía como las máquinas que la generan.

Actualización 1/3/2024, 5:56 pm ET: Esta publicación se ha actualizado con comentarios adicionales de Adobe.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.