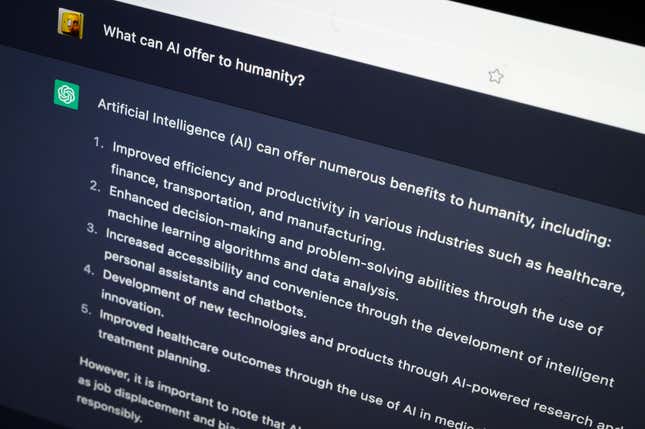

No hay duda de que los chatbots que las empresas de IA están compitiendo por lanzar son impresionantes. puede codificar, escribir discursos, aprobar exámenes, y incluso responder preguntas médicas. Pero eso no significa que no haya habido algunos tropiezos en el camino, algunos de ellos bastante notorios y embarazosos para las empresas detrás de ellos.

Desde confesar su amor y deseo de ser humano, hasta alucinantes jurisprudencias, echa un echa vea la presentación de arriba para algunas de las mayores IA errores del chatbot... hasta ahora.